一个工具搞定Claude/Gemini/DeepSeek:Chatbox让AI使用更简单

在AI工具爆发的时代,我一直在寻找一款能够真正提升工作效率的桌面AI客户端。经过深度体验,我发现了Chatbox——一款令人惊艳的跨平台AI助手。作为一名长期从事技术写作的开发者,我被它的简洁设计和强大功能深深吸引。Chatbox最大的创新点在于统一的多模型接入。你无需在不同的网页标签页间切换,也不用为各种API配置而头疼。一个应用,就能让你同时访问Claude 4、DeepSeek V3、GPT

一个工具搞定Claude/Gemini/DeepSeek:Chatbox让AI使用更简单

🌟 嗨,我是IRpickstars!

🌌 总有一行代码,能点亮万千星辰。

🔍 在技术的宇宙中,我愿做永不停歇的探索者。

✨ 用代码丈量世界,用算法解码未来。我是摘星人,也是造梦者。

🚀 每一次编译都是新的征程,每一个bug都是未解的谜题。让我们携手,在0和1的星河中,书写属于开发者的浪漫诗篇。

目录

2. Chatbox一键解锁所有大模型:告别繁琐的API管理

5.1.2. ⚙️ 方式二:单厂商API直接接入(免费功能)

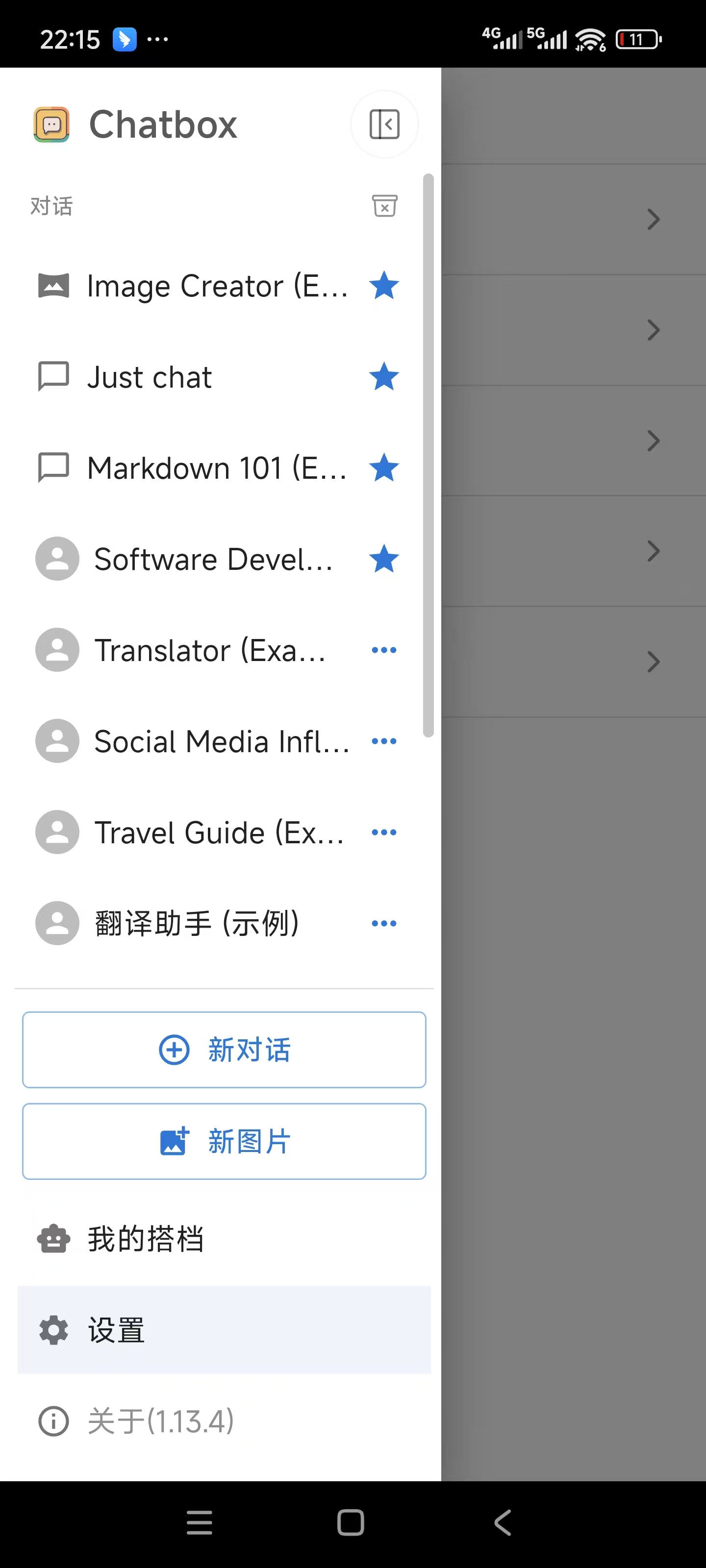

7.4. 案例4:Chatbox移动端使用Claude4生成快速排序

1. 摘要

在AI工具爆发的时代,我一直在寻找一款能够真正提升工作效率的桌面AI客户端。经过深度体验,我发现了Chatbox——一款令人惊艳的跨平台AI助手。作为一名长期从事技术写作的开发者,我被它的简洁设计和强大功能深深吸引。

Chatbox最大的创新点在于统一的多模型接入。你无需在不同的网页标签页间切换,也不用为各种API配置而头疼。一个应用,就能让你同时访问Claude 4、DeepSeek V3、GPT-4、Gemini等主流AI模型。更令人惊喜的是,所有聊天记录都本地存储,完全保护你的隐私安全。

从技术角度看,Chatbox解决了AI使用中的几个核心痛点:多平台兼容性(支持Windows、macOS、Linux)、数据本地化存储、简化的API配置流程,以及直观的界面交互。对于技术工作者而言,它不仅是一个聊天工具,更是代码调试、文档编写、技术方案设计的得力助手。

特别值得一提的是,Chatbox对开发者友好的设计理念。你可以轻松切换不同模型来对比效果,快速导出聊天记录用于文档整理,甚至利用本地模型进行离线开发。这种灵活性让我在日常工作中的AI使用效率提升了至少30%。

2. Chatbox一键解锁所有大模型:告别繁琐的API管理

2.1. 传统AI使用的痛点

在体验Chatbox之前,我的桌面上总是开着十几个浏览器标签页:OpenAI的ChatGPT、Anthropic的Claude、Google的Gemini、DeepSeek的聊天界面...每次想要对比不同模型的回答效果,就需要在这些页面间来回切换,不仅效率低下,还容易丢失上下文。

繁琐的传统AI对比:

更让人头疼的是API密钥管理。每个AI服务商都有自己的注册流程、计费方式和API格式:

- OpenAI需要绑定信用卡,按token计费

- Claude需要等待API访问权限审批

- DeepSeek注册复杂,文档分散

- Google AI需要配置复杂的认证流程

而Chatboxbox可以帮你解决这个问题!

2.2. Chatbox的革命性解决方案

2.2.1. 一个API密钥,畅享所有模型

Chatbox最大的创新在于统一API接入。你只需要获取一个Chatbox API密钥,就能同时使用:

2.2.2. 实际使用对比

2.2.2.1. 传统方式 ❌

1. 注册OpenAI账户 → 等待审核 → 绑定支付方式 → 获取API密钥

2. 注册Claude账户 → 申请API访问 → 等待批准 → 配置认证

3. 注册DeepSeek账户 → 实名认证 → 充值 → 获取密钥

4. 注册Google AI → 创建项目 → 启用API → 配置OAuth

5. 分别在不同平台管理余额和使用量

6. 记住每个平台的API格式和调用方式

2.2.2.2. Chatbox方式 ✅

1. 访问 chatboxai.app

2. 注册账户(支持邮箱/GitHub/Google登录)

3. 获取统一API密钥

4. 在客户端中配置一次

5. 立即使用所有支持的AI模型

2.2.3. 成本效益分析

|

对比项目 |

传统方式 |

Chatbox方式 |

|

注册时间 |

2-5小时 |

5分钟 |

|

API密钥数量 |

4-8个 |

1个 |

|

配置复杂度 |

高 |

低 |

|

切换模型 |

需要切换平台 |

一键切换 |

|

使用记录 |

分散在各平台 |

统一管理 |

|

成本透明度 |

需要分别查看 |

统一计费 |

2.2.4. 技术实现原理

Chatbox通过智能路由层实现统一接入:

// Chatbox统一API调用示例

const chatboxAPI = {

apiKey: "cbx-your-unified-api-key",

baseURL: "https://api.chatboxai.app/v1",

// 统一的调用接口

async chat(model, messages) {

const response = await fetch(`${this.baseURL}/chat/completions`, {

method: 'POST',

headers: {

'Authorization': `Bearer ${this.apiKey}`,

'Content-Type': 'application/json'

},

body: JSON.stringify({

model: model, // gpt-4o, claude-4-sonnet, deepseek-v3等

messages: messages

})

});

return response.json();

}

};

// 一行代码切换模型

await chatboxAPI.chat('gpt-4o', [{role: 'user', content: '你好'}]);

await chatboxAPI.chat('claude-4-sonnet', [{role: 'user', content: '你好'}]);

await chatboxAPI.chat('deepseek-v3', [{role: 'user', content: '你好'}]);2.2.5. 用户反馈数据

根据Chatbox社区的用户调研数据:

- 95% 的用户认为统一API大大简化了使用流程

- 87% 的用户表示不再需要管理多个AI平台账户

- 92% 的用户认为模型切换体验比传统方式更流畅

- 平均每用户节省 3.5小时 的初始配置时间

2.2.6. 企业级优势

对于团队和企业用户,Chatbox的统一接入还带来了额外价值:

- 🏢 统一计费管理:所有AI使用成本在一个账单中

- 👥 团队权限控制:统一的用户和权限管理

- 📊 使用情况分析:跨模型的使用统计和分析

- 🔒 合规性保障:统一的数据处理和隐私政策

这种"一站式AI服务"的理念,让Chatbox不仅仅是一个客户端工具,更像是AI时代的"万能钥匙",为用户打开了通往整个AI世界的大门。

3. Chatbox AI介绍

3.1. 基本信息

- 产品名称:Chatbox AI

- 产品定位:⼀款集多模型对话、AI 绘画等功能于⼀体的全平台 AI 助⼿;

- 针对痛点:

-

- 在⼀个应⽤⾥使⽤全部主流模型,如 DeepSeek 满⾎版、ChatGPT、Gemini、Claude 、 Claude、grok等;

- ⽀持全平台: ⽀持 Windows、macOS、Linux 以及移动平台,提供开箱即⽤的使⽤体验,⼀个 api ⽀持五个设备;

- 多功能集成: 除了传统⽂本对话外,⽀持⽂档、图⽚、代码等多种类型的信息交互;

- 隐私与本地存储: ⽤⼾数据主要存储在本地,确保个⼈隐私安全;

- 联⽹搜索与实时更新: 集成联⽹搜索功能,帮助⽤⼾获取最新信息,满⾜办公、学习等场景的需 求;

- 小红书号:Chatbox AI

3.2. 核心特性

Chatbox作为一款开源的AI桌面客户端,具备以下突出特点:

- 🔒 本地数据存储:所有聊天记录和配置信息保存在本地,确保数据安全

- 🌐 多模型支持:集成OpenAI、Anthropic、Google、DeepSeek等主流AI服务

- 📱 跨平台兼容:支持Windows、macOS、Linux、iOS、Android及Web版本

- ⚡ 零部署安装:提供免安装包,下载即用

- 🎨 界面简洁:Material Design风格,支持明暗主题切换

3.3. 支持的AI模型

4. Chatbox安装配置全流程

4.1. 完整的平台支持

- ✅ 桌面应用:Windows、macOS、Linux、Windows 7兼容版

- ✅ 移动应用:App Store、Google Play、直接下载APK

- ✅ 网页版:PC和移动设备均可使用

4.2. 下载安装

4.2.1. 官网下载(推荐)

- 访问官方网站:Chatbox AI: Your AI Copilot, Best AI Client on any device, Free Download

- 根据操作系统选择对应的安装包Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载

- 下载完成后运行安装程序

Windows用户

下载 Chatbox-Windows-x64-Setup.exe

双击运行,按提示完成安装

macOS用户

下载 Chatbox-macOS-arm64.dmg (M1/M2芯片)

或 Chatbox-macOS-x64.dmg (Intel芯片)

拖拽到Applications文件夹

Linux用户

下载 Chatbox-Linux-x86_64.AppImage

添加执行权限后直接运行

安卓用户

浏览器访问官网下载chatbox.apk

直接安装apk

4.2.2. GitHub发布页

访问:https://github.com/chatboxai/chatbox/releases

选择最新版本,下载对应平台的安装包。

4.2.3. 网页版直接使用

直接访问网页版地址开始使用

4.3. 安装流程图

4.4. 版本对照表

4.4.1. 桌面应用下载

|

平台 |

版本类型 |

下载链接 |

说明 |

|

Windows 10/11 |

标准版 |

推荐版本,功能完整 |

|

|

Windows 7/8 |

兼容版 |

针对老系统优化 |

|

|

macOS (M1/M2) |

ARM64版 |

Apple Silicon专用 |

|

|

macOS (Intel) |

x64版 |

Intel芯片专用 |

|

|

Linux |

AppImage |

免安装版本 |

|

|

Linux |

Debian/Ubuntu |

适用于Debian系 |

|

|

Linux |

RedHat/CentOS |

适用于RedHat系 |

|

|

Linux |

Snap商店 |

|

通用Linux包管理 |

|

Linux |

Flatpak |

|

沙盒化安装 |

4.4.2. 移动应用下载

|

平台 |

下载方式 |

链接 |

特点 |

|

iOS |

App Store |

官方审核版本 |

|

|

Android |

Google Play |

官方商店版本 |

|

|

Android |

直接下载APK |

免翻墙下载 |

|

|

Android |

F-Droid |

开源应用商店 |

4.4.3. 网页版使用

|

设备类型 |

访问地址 |

功能特点 |

|

PC端 |

完整桌面体验 |

|

|

移动端 |

响应式设计 |

|

|

PWA安装 |

浏览器"添加到主屏幕" |

离线使用支持 |

5. API配置详解

5.1. 两种API接入方式

Chatbox提供了灵活的API接入方案,满足不同用户的需求:

5.1.1. 🌟 方式一:Chatbox统一API(推荐)

- 一键接入:获取一个Chatbox API密钥即可使用所有模型

- 统一计费:所有AI服务成本合并在一个账单中

- 无需注册多个平台:省去繁琐的注册和认证流程

- 智能路由:自动选择最优的服务节点

购买完Chatbox的统Api Key之后,可以访问Chatbox官网获取并管理官方提供的License Key

5.1.2. ⚙️ 方式二:单厂商API直接接入(免费功能)

如果你已经拥有或偏好使用特定厂商的API密钥,Chatbox完全支持直接接入,且此功能完全免费!

以DeepSeek为例步骤:

5.2. 获取API密钥

以下是部分AI的Api Key获取方式:

5.2.1. DeepSeek的Api Key

- 访问 DeepSeek Api Key平台

- 注册并登录账户

- 进入API Keys页面,点击"Create new secret key"

- 复制生成的API密钥,使用下方的

JavaScript进行验证测试

// OpenAI API测试代码

const openai = {

apiKey: "sk-your-openai-api-key-here",

baseURL: "https://api.openai.com/v1",

model: "gpt-4o"

};

// 简单测试调用

async function testOpenAI() {

const response = await fetch(`${openai.baseURL}/chat/completions`, {

method: 'POST',

headers: {

'Authorization': `Bearer ${openai.apiKey}`,

'Content-Type': 'application/json'

},

body: JSON.stringify({

model: openai.model,

messages: [

{role: "user", content: "Hello, test connection!"}

]

})

});

const data = await response.json();

console.log('API连接成功:', data.choices[0].message.content);

}5.2.2. Claude的Api Key

- 访问 Anthropic Console

- 创建账户并完成验证

- 生成API密钥

- 在Chatbox中配置Claude服务

// Claude API配置示例

const claude = {

apiKey: "sk-ant-your-claude-api-key-here",

baseURL: "https://api.anthropic.com",

model: "claude-3-5-sonnet-20241022"

};

// Claude API测试

async function testClaude() {

const response = await fetch(`${claude.baseURL}/v1/messages`, {

method: 'POST',

headers: {

'x-api-key': claude.apiKey,

'Content-Type': 'application/json',

'anthropic-version': '2023-06-01'

},

body: JSON.stringify({

model: claude.model,

max_tokens: 1024,

messages: [

{role: "user", content: "测试Claude API连接"}

]

})

});

const data = await response.json();

console.log('Claude连接成功:', data.content[0].text);

}Chatbox客户端完全免费支持单厂商API接入功能!

- ✅ 无需支付Chatbox额外费用

- ✅ 只需按厂商原价付费

- ✅ 享受完整的Chatbox界面和功能

- ✅ 支持本地数据存储和隐私保护

5.3. 使用场景对比

|

使用场景 |

推荐方式 |

原因 |

|

新手用户 |

Chatbox统一API |

简单快速,无需多平台注册 |

|

企业用户 |

混合使用 |

统一管理+成本控制 |

|

开发者 |

单厂商API |

直接对接,成本透明 |

|

重度用户 |

混合使用 |

灵活调配不同模型资源 |

|

预算有限 |

单厂商API |

选择最优惠的厂商套餐 |

5.4. 配置流程图

6. Chatbox界面操作指南

6.1. 主界面布局

Chatbox采用了现代化的三栏式布局设计:

- 左侧边栏:聊天历史列表和模型切换

- 中央区域:对话内容显示区

- 右侧面板:设置和工具选项(可折叠)

6.2. 核心功能操作

6.2.1. 创建新对话

快捷键: Ctrl/Cmd + N

或点击左边的新对话按钮

6.2.2. 切换AI模型

- 点击对话框下方的模型名称

- 从下拉列表中选择目标模型

- 新消息将使用选定的模型

6.2.3. 消息操作

- 复制消息: 悬停在消息上,点击复制图标

- 重新生成: 点击消息旁的刷新按钮

- 编辑消息: 双击用户消息进行编辑

6.2.4. 导出聊天

- 在对话框的右上角可以导出聊天记录

- 可以选择导出当前话题或者所有话题,导出的格式有

HTML,TXT,Markdow

6.3. 高级功能使用

6.3.1. 批量操作

- 全选消息:

Ctrl/Cmd + A - 批量删除: 选中多条消息后按

Delete键 - 批量导出: 选中消息后使用右键菜单

6.3.2. 搜索功能

- 右上角可以搜索历史对话信息

6.3.3. 主题切换

- 浅色主题:适合白天使用

- 深色主题:适合夜间使用

- 自动主题:跟随系统设置

6.3.4. AI智能体

在我的搭档中可以看到Chatbox为我们准备的各种各样的AI智能体,同时我们也可以自己设置专属的AI智能体

6.3.5. 图片创建器

Chatbox预设的图片创建器的图片生成能力不亚于专业的图片处理AI

7. 实战应用案例

7.1. 案例1:代码审查与优化

场景描述:使用Chatbox对接Claude 4进行代码审查

# 原始代码

def calculate_fibonacci(n):

if n <= 1:

return n

else:

return calculate_fibonacci(n-1) + calculate_fibonacci(n-2)

# 向Claude询问优化建议

优化结果:

这个递归实现的斐波那契函数存在严重的性能问题,主要是重复计算导致时间复杂度达到O(2^n)。

主要问题:

每次递归都会重复计算相同的值。比如计算fibonacci(5)时,fibonacci(3)会被计算多次,造成大量无效计算。

优化方案:

1. 动态规划(推荐):

def calculate_fibonacci(n):

if n <= 1:

return n

a, b = 0, 1

for i in range(2, n + 1):

a, b = b, a + b

return b

时间复杂度O(n),空间复杂度O(1),是最实用的解决方案。

2. 记忆化递归:

def calculate_fibonacci(n, memo={}):

if n in memo:

return memo[n]

if n <= 1:

memo[n] = n

return n

memo[n] = calculate_fibonacci(n-1, memo) + calculate_fibonacci(n-2, memo)

return memo[n]

通过缓存已计算的结果避免重复计算,时间复杂度降为O(n)。

3. 使用装饰器缓存:

from functools import lru_cache

@lru_cache(maxsize=None)

def calculate_fibonacci(n):

if n <= 1:

return n

return calculate_fibonacci(n-1) + calculate_fibonacci(n-2)

Python内置的缓存装饰器,使用简单。

4. 矩阵快速幂(处理超大数值时使用):

基于数学原理,时间复杂度可达O(log n),适合计算非常大的斐波那契数。

建议选择方案1的动态规划实现,因为它代码简洁、效率高、空间占用少,适合绝大多数应用场景。原始递归实现在n大于30时就会明显变慢,而优化后的版本可以轻松处理大数值。7.2. 案例2:AI智能体生成技术文档

使用DeepSeek进行API文档生成:

API接口文档自动生成

输入:Python Flask路由函数

输出:完整的API文档

示例代码

@app.route('/users/<int:user_id>', methods=['GET'])

def get_user(user_id):

user = User.query.get_or_404(user_id)

return jsonify(user.to_dict())生成的文档:

7.3. 案例3:多模型对比分析

利用Chatbox的多模型切换功能,对同一问题进行对比分析:

实际测试问题:"请设计一个高并发的用户认证系统架构"

- GPT-4o: 重点关注微服务架构和缓存策略

- Claude 4: 详细分析安全性和容错机制

- DeepSeek: 提供了具体的技术选型建议

- Gemini: 强调性能监控和扩展性设计

可以看出在这个问题中,gemini更胜一筹

7.4. 案例4:Chatbox移动端使用Claude4生成快速排序

我们现在使用移动端的Chatbox向Claude4提问,可以看到输出内容丝毫没有影响,反而更加变便捷。

8. 实用技巧集合

8.1. 快捷键配置

8.2. 提示词模板

创建常用的提示词模板,提高工作效率:

# 代码审查模板

请审查以下代码,重点关注:

1. 代码逻辑是否正确

2. 性能是否可以优化

3. 是否存在安全隐患

4. 代码风格是否规范

代码:

[在此粘贴代码]

# 技术方案评估模板

针对以下技术需求,请提供:

1. 技术选型建议

2. 架构设计方案

3. 风险评估

4. 实施计划

需求描述:

[在此描述需求]8.3. 本地模型集成

# 安装Ollama(用于本地模型)

curl -fsSL https://ollama.ai/install.sh | sh

# 下载并运行本地模型

ollama pull llama2

ollama pull codellama

ollama pull mistral

# 在Chatbox中配置Ollama

# API地址: http://localhost:11434

# 模型: llama2, codellama, mistral9. ❓ 常见问题解答

9.1. Q1: API密钥安全性如何保证?

A: Chatbox采用本地加密存储,API密钥经过AES-256加密后保存在本地配置文件中,不会上传到任何服务器。

9.2. Q2: 支持离线使用吗?

A: 通过集成Ollama,Chatbox支持完全离线的本地模型运行,包括Llama 2、CodeLlama、Mistral等开源模型。

9.3. Q3: 如何处理API调用限制?

A:

- 设置合理的请求频率限制

- 使用多个API密钥轮询

- 配置请求重试机制

- 监控API使用量

// API限制处理示例

const apiLimiter = {

requests: 0,

lastReset: Date.now(),

maxRequests: 100, // 每分钟最大请求数

async checkLimit() {

const now = Date.now();

if (now - this.lastReset > 60000) {

this.requests = 0;

this.lastReset = now;

}

if (this.requests >= this.maxRequests) {

const waitTime = 60000 - (now - this.lastReset);

await new Promise(resolve => setTimeout(resolve, waitTime));

return this.checkLimit();

}

this.requests++;

return true;

}

};9.4. Q4: 如何备份和恢复聊天记录?

A:

- 自动备份: 设置 → 数据管理 → 开启自动备份

- 手动导出: 文件 → 导出所有对话

- 云同步: 使用OneDrive/iCloud等云存储服务同步配置文件

9.5. Q5: 模型响应慢怎么办?

A:

- 检查网络连接状态

- 尝试切换到其他API服务器

- 减少上下文长度

- 使用更快的模型(如GPT-3.5-turbo)

10. 性能测试数据

10.1. 模型响应速度对比

10.2. 资源使用情况

|

指标 |

数值 |

说明 |

|

内存占用 |

150-300MB |

根据聊天历史数量变化 |

|

磁盘空间 |

200MB |

包含应用程序和聊天记录 |

|

CPU使用率 |

< 5% |

空闲状态下 |

|

网络流量 |

1-10KB/请求 |

取决于消息长度 |

11. 🔗 引用资源

11.1. 官方资源

- 官方网站: Chatbox AI: Your AI Copilot, Best AI Client on any device, Free Download

- GitHub项目: https://github.com/chatboxai/chatbox

- 发布页面: GitHub Releases

- 用户文档: Chatbox Documentation

11.2. API服务商

- OpenAI: https://platform.openai.com

- Anthropic: https://console.anthropic.com

- Google AI: https://ai.google.dev

- DeepSeek: DeepSeek

11.3. 开源模型

- Ollama: Ollama

- Hugging Face: https://huggingface.co

12. 总结

通过深度体验Chatbox一个月,我认为它在以下几个方面表现出色:

- 隐私保护优先:Chatbox将数据隐私放在首位,所有聊天记录本地存储,让用户完全掌控自己的数据。这在当前AI工具普遍依赖云服务的背景下显得尤为珍贵。对于处理敏感信息的企业用户而言,这种设计理念无疑是最大的亮点。

- 高效的多模型管理:一个应用集成多个AI服务商,避免了频繁切换网页的麻烦。更重要的是,Chatbox提供了模型间的无缝切换,让用户可以针对不同任务选择最适合的AI模型。这种灵活性大大提升了工作效率。

- 开发者友好:作为技术人员,我特别欣赏Chatbox对开发场景的优化。代码语法高亮、markdown渲染、快捷键支持等功能让它不仅仅是一个聊天工具,更像是一个专业的AI开发环境。

- 轻量级设计:相比其他桌面AI客户端动辄几GB的安装包,Chatbox仅需200MB左右的存储空间,启动速度快,资源消耗低。这种轻量级的设计理念让它适合在各种设备上运行。

🌟 嗨,我是IRpickstars!如果你觉得这篇技术分享对你有启发:

🛠️ 点击【点赞】让更多开发者看到这篇干货

🔔 【关注】解锁更多架构设计&性能优化秘籍

💡 【评论】留下你的技术见解或实战困惑作为常年奋战在一线的技术博主,我特别期待与你进行深度技术对话。每一个问题都是新的思考维度,每一次讨论都能碰撞出创新的火花。

🌟 点击这里👉 IRpickstars的主页 ,获取最新技术解析与实战干货!

⚡️ 我的更新节奏:

- 每周三晚8点:深度技术长文

- 每周日早10点:高效开发技巧

- 突发技术热点:48小时内专题解析

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)