AI-调查研究-67-具身智能 核心技术构成全解析:感知、决策、学习与交互的闭环系统

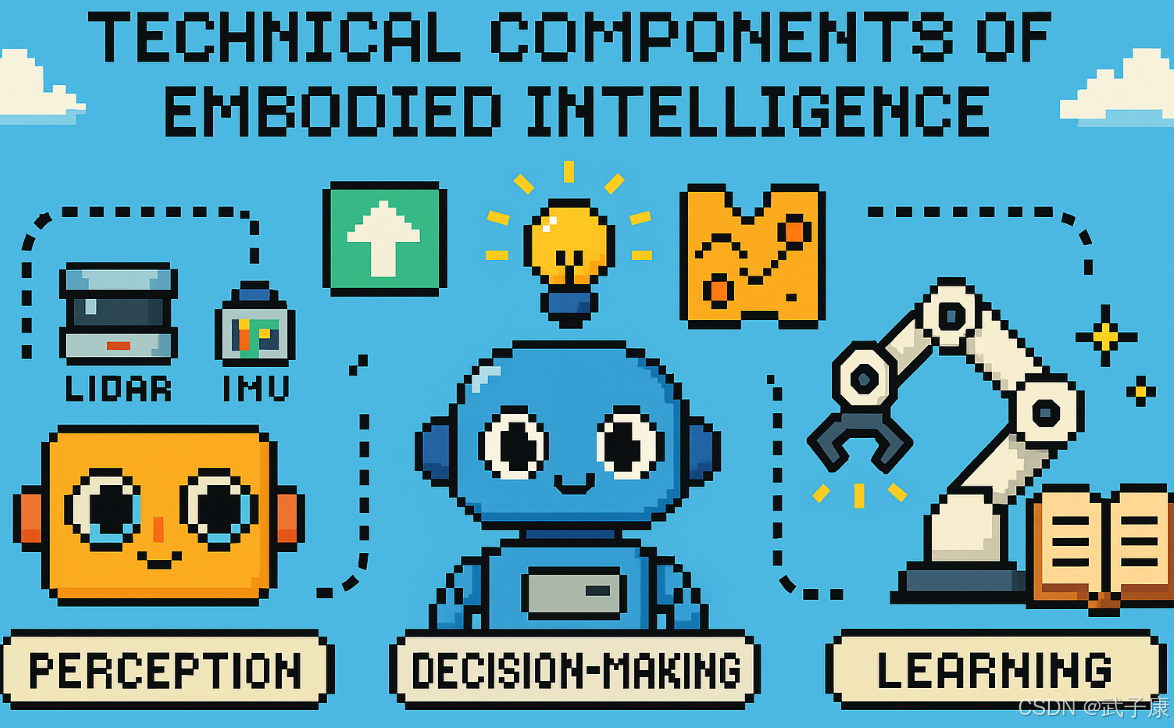

具身智能的技术构成可概括为“感知—决策—控制—学习—交互”闭环系统。感知层由多种传感器(视觉、雷达、IMU、触觉等)和算法(SLAM、目标检测、多模态融合)组成,为机器人提供环境建模与物体识别能力。决策控制模块是核心“大脑”,高层采用深度学习、规划与强化学习进行策略生成,低层通过PID、MPC等算法实现精确动作执行,并逐渐发展为端到端和分布式架构。学习与适应依托深度强化学习、模仿学习和进化算法,辅

点一下关注吧!!!非常感谢!!持续更新!!!

🚀 AI篇持续更新中!(长期更新)

AI炼丹日志-31- 千呼万唤始出来 GPT-5 发布!“快的模型 + 深度思考模型 + 实时路由”,持续打造实用AI工具指南!📐🤖

💻 Java篇正式开启!(300篇)

目前2025年09月01日更新到:

Java-113 深入浅出 MySQL 扩容全攻略:触发条件、迁移方案与性能优化

MyBatis 已完结,Spring 已完结,Nginx已完结,Tomcat已完结,分布式服务正在更新!深入浅出助你打牢基础!

📊 大数据板块已完成多项干货更新(300篇):

包括 Hadoop、Hive、Kafka、Flink、ClickHouse、Elasticsearch 等二十余项核心组件,覆盖离线+实时数仓全栈!

大数据-278 Spark MLib - 基础介绍 机器学习算法 梯度提升树 GBDT案例 详解

AI 辅助调查报告

技术构成 (Technical Components)

感知系统

感知系统是具身智能的基础感官系统,由硬件传感器和软件处理算法组成,为智能体提供环境感知能力。现代具身智能的感知系统主要包含以下关键组件:

硬件传感器

-

视觉传感器:

- 单目/双目摄像头:提供RGB彩色图像和深度信息

- 全景相机:360度环境感知

- 红外摄像头:夜间或低光环境下的视觉能力

- 事件相机:基于像素级变化的超低延迟视觉

-

距离传感器:

- LiDAR激光雷达:通过激光测距构建高精度3D点云

- 毫米波雷达:全天候测距能力

- 超声波传感器:近距离障碍物检测

-

运动传感器:

- IMU(惯性测量单元):测量加速度和角速度

- 轮式编码器:里程计信息

- GPS/北斗:全局定位

-

触觉传感器:

- 压力传感器阵列

- 力/力矩传感器

- 柔性电子皮肤

感知算法

-

环境理解:

- 3D SLAM(如ORB-SLAM3、LIO-SAM):实时构建3D环境地图

- 语义分割:识别环境中的可通行区域

- 深度估计:计算物体距离

-

物体识别:

- 基于深度学习的目标检测(YOLO、Faster R-CNN)

- 物体分类与识别

- 物体跟踪算法

-

多模态融合:

- 传感器标定与配准

- 多源数据融合(如相机+LiDAR)

- 跨模态特征提取

典型应用场景

- 自动驾驶:融合相机、LiDAR和雷达数据,实现车道线检测、障碍物识别和路径规划

- 服务机器人:通过视觉+语音识别理解用户指令,完成物品递送等任务

- 工业机器人:结合力觉传感器实现精密装配操作

- AR/VR:实时环境重建和空间定位

技术挑战与发展趋势

- 实时性要求:需要优化算法满足毫秒级响应

- 鲁棒性提升:应对光照变化、天气影响等复杂环境

- 边缘计算:将部分感知任务下放到终端设备

- 神经形态传感器:模仿生物感知机制的新型传感器

- 多智能体协同感知:通过多个智能体共享感知信息

现代具身智能系统正朝着多模态深度融合的方向发展,通过结合视觉、听觉、触觉等多种感知通道,构建更接近人类的环境理解能力。同时,随着传感器小型化和算法优化,感知系统正变得更加轻量化和高效。

决策控制

决策与控制模块是智能体系统的核心处理单元,相当于生物体的"大脑"和"神经系统"。它负责接收感知系统输入的环境信息,经过智能处理后输出控制指令,协调各个执行机构完成既定任务。现代智能体的决策控制系统通常采用分层架构设计,包含以下两个关键层次:

1. 高层决策系统

高层决策系统通过人工智能算法对感知数据进行语义理解和任务解析,生成合理的行为策略。主要实现方式包括:

- 深度学习模型:如卷积神经网络处理视觉输入,递归神经网络处理时序信息

- 规划算法:包括A*、D*等路径规划算法,以及STRIPS、PDDL等任务规划语言

- 强化学习:通过Q-learning、策略梯度等方法学习最优决策策略

应用场景示例:

- 服务机器人在家庭环境中,基于RGB-D相机输入的3D点云数据,使用语义分割识别各类家具物品,然后通过任务规划算法生成整理房间的合理步骤序列

- 自动驾驶车辆通过融合多传感器数据,利用深度强化学习模型在复杂交通场景中做出超车、变道等决策

- 工业机器人运用启发式搜索算法在动态变化的工厂环境中规划最优装配路径

2. 低层控制系统

低层控制系统将高层决策转化为精确的执行指令,其核心是各类控制理论算法:

- 反馈控制:PID控制、自适应控制等

- 先进控制算法:模型预测控制(MPC)、滑模控制等

- 运动控制:逆运动学求解、轨迹插补等

典型实现方式:

- 机械臂关节的伺服电机控制,通过PID调节确保末端执行器精准定位

- 无人机使用MPC算法实时调整旋翼转速以保持稳定飞行

- 轮式机器人通过轮速差控制实现精确转向

架构演进

传统机器人系统采用串行处理架构:

- 感知模块构建环境模型

- 规划模块生成动作序列

- 控制模块执行具体动作

现代具身智能系统发展出更先进的架构:

- 闭环实时协同:在动态环境中,规划与控制需要紧密耦合,形成快速响应闭环

- 分布式控制:借鉴生物神经系统原理,采用分散式处理单元

- 端到端学习:通过深度神经网络直接从原始感知输入映射到控制输出,例如:

- 使用CNN-LSTM网络处理视频流,直接输出机械臂关节角度

- 基于强化学习的端到端自动驾驶系统,从摄像头到方向盘控制

技术对比:

| 架构类型 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| 分层架构 | 模块清晰,易于调试 | 响应延迟大 | 结构化环境 |

| 端到端架构 | 响应快速,适应性强 | 可解释性差 | 动态复杂环境 |

| 分布式架构 | 鲁棒性强 | 协调难度大 | 多智能体系统 |

学习与适应

具身智能系统需要通过持续学习来提升自身能力,以应对复杂多变的环境和任务需求。当前主要采用以下几种学习方法:

深度强化学习(Deep Reinforcement Learning)

作为最核心的技术之一,深度强化学习使智能体能够通过与环境反复交互、试错来自动获取最优策略。其基本框架遵循"行动-观察-反馈"的循环模式:

- 智能体观察当前环境状态

- 根据策略选择并执行动作

- 接收环境反馈(奖励/惩罚)

- 更新策略网络参数

- 重复上述过程直至收敛

典型案例包括:

- 无人机竞速:通过深度RL训练,无人机可在复杂赛道上实现冠军级飞行表现

- 机械臂操控:机器人成功掌握精确抓取、装配等高难度操作技能

其他重要学习方法

-

模仿学习(Imitation Learning):

- 通过观察人类专家演示获取初始策略

- 适用于动作空间复杂、难以定义奖励函数的任务

- 示例:机器人学习物体抓取、行走等基础动作

-

进化算法(Evolutionary Algorithms):

- 模拟自然选择过程优化策略

- 适用于非连续、非可微分的优化问题

- 常见应用于机器人形态设计、运动控制等

训练挑战与解决方案

现实训练面临的主要困难:

- 物理实验成本高:机器人硬件损耗大

- 训练周期长:现实时间尺度限制

- 安全风险:不可预测的行为可能造成损害

通用解决方案:

- 构建高保真仿真环境

- 使用物理引擎(如PyBullet、MuJoCo)

- 建立数字孪生系统

- 采用迁移学习技术

- 先在仿真环境预训练

- 再通过域适应方法迁移到现实

- 渐进式训练策略

- 从简单任务开始

- 逐步增加环境复杂度

未来发展前景

随着算法进步和计算能力提升,具身智能系统有望实现:

- 持续自主进化能力

- 跨任务知识迁移

- 类生物的学习效率

这将显著提升机器人在非结构化环境中的适应性和实用性。

多模态感知与交互

多模态感知与交互是具身智能系统的核心能力,它使机器人能够像人类一样通过多种感官通道理解和交互世界。这一技术体系主要包含以下两个关键方面:

多模态感知系统

-

感知模态的多样性:

- 视觉感知:采用RGB-D相机、立体视觉等设备获取环境信息,如物体识别(YOLO等算法)、场景理解(语义分割)、人脸识别等

- 听觉感知:通过麦克风阵列实现声源定位、语音识别(如ASR系统)、情感识别等

- 触觉感知:使用力/力矩传感器、触觉传感器阵列(如TacTip)实现力度控制、材质识别

- 其他感知:包括嗅觉传感器、温度传感器等特殊感知方式

-

多模态融合技术:

- 早期融合:在原始数据层面进行特征融合

- 中期融合:在特征层面进行融合

- 晚期融合:在决策层面进行融合

- 典型应用场景:在光线不足时,语音命令可以补充视觉信息;在嘈杂环境中,视觉信息可以验证语音指令

-

鲁棒性增强机制:

- 传感器冗余设计

- 故障检测与补偿算法

- 不确定性建模与处理

多模态交互系统

-

交互方式:

- 语音交互:包括语音合成(TTS)、自然语言理解(NLU)、对话管理

- 视觉交互:显示屏、投影、LED表情显示

- 动作交互:手势识别、肢体语言、头部运动

- 触觉反馈:震动提示、力反馈

-

典型应用场景:

- 服务机器人:

- 餐厅场景:通过语音接收订单,显示屏展示菜单,机械臂完成递送

- 酒店场景:数字人形象提供迎宾服务,结合语音和表情进行交流

- 工业机器人:

- 通过视觉定位工件,触觉调整抓取力度

- 接收语音指令完成特定操作

- 服务机器人:

-

社交增强技术:

- 情感计算:通过面部表情识别、语音情感分析等理解用户情绪

- 个性建模:建立符合场景需求的交互风格

- 上下文感知:记忆历史交互信息,保持对话连贯性

技术挑战与发展

-

关键挑战:

- 多模态数据的时间对齐问题

- 异构特征的有效融合

- 实时性要求与计算资源的平衡

- 长尾场景的覆盖能力

-

前沿方向:

- 基于Transformer的多模态预训练模型

- 神经符号系统的结合应用

- 小样本学习与持续学习技术

- 具身多模态大语言模型(如PaLM-E)

随着传感器技术、人工智能算法和计算硬件的持续进步,多模态感知与交互能力正在使机器人系统越来越接近人类的自然交互水平,为各类服务、制造和社交场景提供更智能的解决方案。

具身大模型:融合AI大模型与机器人技术的智能系统

概念与定义

具身大模型(Embodied Foundation Models)是指将大规模预训练模型(如LLM、VLM)与机器人系统深度融合的新型智能范式。这类模型通过将深度学习获得的大规模知识库和推理能力"具现化"到物理实体中,实现机器人在真实环境中的智能交互和行为执行。

技术组成

-

核心组件

- 大型语言模型(LLM):如GPT-4、PaLM等,提供语义理解和逻辑推理能力

- 视觉-语言模型(VLM):如CLIP、Flamingo等,实现视觉场景理解与跨模态对齐

- 机器人控制系统:负责将认知决策转化为具体动作

-

典型架构

- 认知层:大模型处理自然语言指令和环境感知

- 规划层:生成可行的任务执行方案

- 执行层:通过传统控制算法实现动作执行

核心能力

-

语义理解与推理

- 理解复合指令(如"把冰箱里快过期的牛奶拿出来")

- 处理隐含需求(通过常识推理补全缺失信息)

- 示例:机器人能理解"帮我找放在客厅的那个蓝色文件夹"中的空间关系和物体属性

-

多模态感知与交互

- 视觉-语言联合建模实现场景理解

- 跨模态信息转换(如将语音指令转化为导航路径)

- 应用场景:通过视觉问答确认操作对象(“是这个红色的按钮吗?”)

-

任务规划与决策

- 分解复杂任务为可执行步骤

- 动态调整计划(应对环境变化)

- 典型案例:完成"准备早餐"任务时自主规划取餐具、加热食物等子任务

关键技术突破

-

环境自适应

- 通过few-shot learning快速适应新场景

- 增量学习更新环境知识库

-

安全与可靠性

- 不确定性建模与风险评估

- 物理约束条件下的动作生成

-

人机协作

- 自然语言交互接口

- 意图识别与主动询问机制

应用前景

-

家庭服务

- 个性化家政服务

- 老年护理与陪伴

-

工业场景

- 柔性生产线管理

- 复杂设备维护

-

特殊环境

- 灾害救援

- 太空探索

当前挑战

- 实时性要求与模型计算开销的矛盾

- 仿真到现实(Sim2Real)的迁移问题

- 长期任务中的状态保持与记忆管理

- 多模态信息的时间同步与融合

随着模型压缩、边缘计算等技术的发展,具身大模型正逐步突破实验室环境,向实际应用场景加速落地。这种新型智能范式有望重新定义人机协作方式,推动服务机器人产业进入新阶段。

暂时小结

综上,具身智能的技术构成是一个感知-认知-行动-学习的闭环系统,其运作机制可具体描述为:

-

多模态感知系统:通过视觉传感器(如RGB-D相机)、触觉传感器(如力/力矩传感器)、听觉设备(如麦克风阵列)等多种传感设备采集环境信息。例如,一个家庭服务机器人可能同时使用摄像头识别物体,麦克风接收语音指令,以及激光雷达构建环境地图。

-

高级认知模型:基于深度学习和大语言模型的环境理解和决策系统。这类模型能够:

- 理解感知数据的语义信息(如识别"水杯"这一物体及其位置)

- 推理任务目标(如"将水杯移到茶几上")

- 规划行动序列(如先导航到水杯位置,再执行抓取动作)

-

运动控制系统:将决策转化为精确的物理动作,包括:

- 运动规划算法(如RRT*路径规划)

- 实时控制回路(如PID关节控制)

- 安全机制(如碰撞检测和避障)

-

持续学习机制:通过以下方式实现系统迭代优化:

- 在线学习(如强化学习调整抓取策略)

- 仿真训练(在虚拟环境中预演任务)

- 经验回放(存储成功案例供后续参考)

这些组件通过紧密协作形成闭环:感知系统采集的数据驱动认知决策,决策结果指导行动执行,行动效果又反馈给学习系统改进性能。这种架构使机器人能够像生物体一样,在动态环境中完成从简单物品搬运到复杂社交互动等多层次任务,并随着经验积累不断提升任务完成率和适应性。当前研究重点包括提高系统实时性、增强泛化能力,以及解决模拟到现实的迁移问题。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)